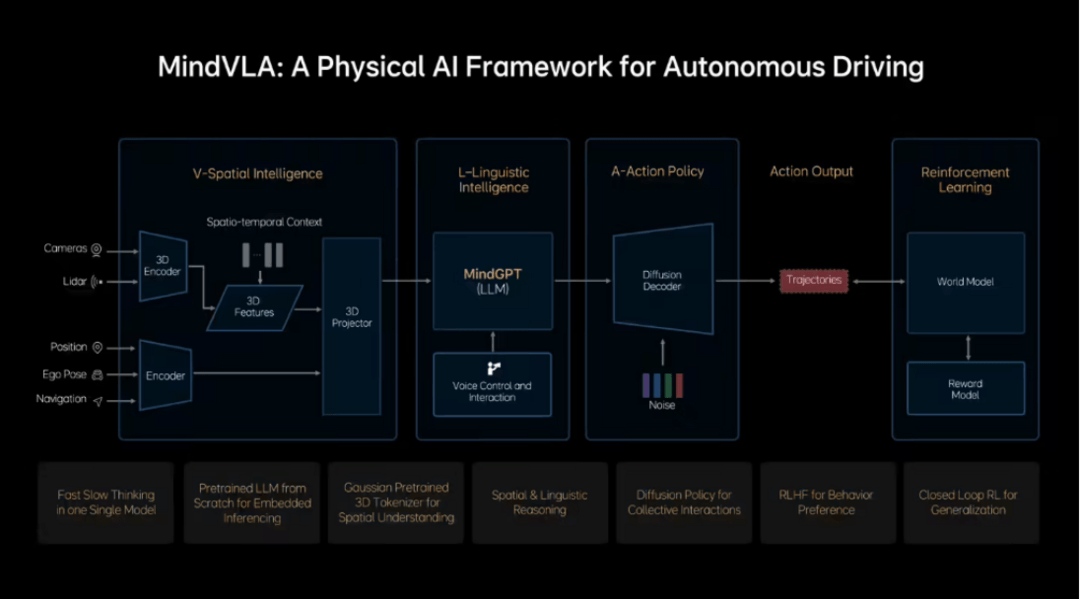

MindVLA是一个视觉-语言-行为大模型,整合了空间智能、语言智能和行为智能。它能够让车辆“听得懂”用户的语音指令,自主调整路线和行为,例如在没有导航的情况下找到目的地或根据用户反馈调整驾驶速度;“看得见”周围环境,识别商店招牌并根据用户发送的照片找到位置;“找得到”车位或目的地,利用空间推理能力在复杂场景中自主漫游和停车。这些功能均不依赖传统地图或导航信息,而是通过模型的空间理解和逻辑推理能力实现。理想汽车CEO李想表示,MindVLA将重新定义自动驾驶,就如同iPhone 4重新定义手机一样。MindVLA 也是一个视觉-语言-行为大模型,但我们更愿意将其称为‘机器人大模型’,它将空间智能、语言智能和行为智能统一在一个模型里,让自动驾驶拥有感知、思考和适应环境的能力,是通往 L4 路上最重要的一步。

CONTACT US

CONTACT US ICC APP

ICC APP